La prensa ha jugado un papel crucial en la forma en que entendemos la evolución de la inteligencia artificial (IA), utilizando metáforas y ejemplos que simplifican conceptos complejos. Con el auge de los chatbots impulsados por IA, se ha intensificado la tendencia a humanizar la tecnología. Comparaciones con el ámbito médico, símiles bien conocidos y visiones distópicas han tomado protagonismo en los artículos, presentando algoritmos y sistemas de IA como entidades con capacidades humanas. Esta humanización no solo busca ayudar a los lectores a comprender la magnitud y naturaleza de estas tecnologías; también establece un marco de referencia que a menudo distorsiona nuestra percepción de lo que la IA realmente puede hacer.

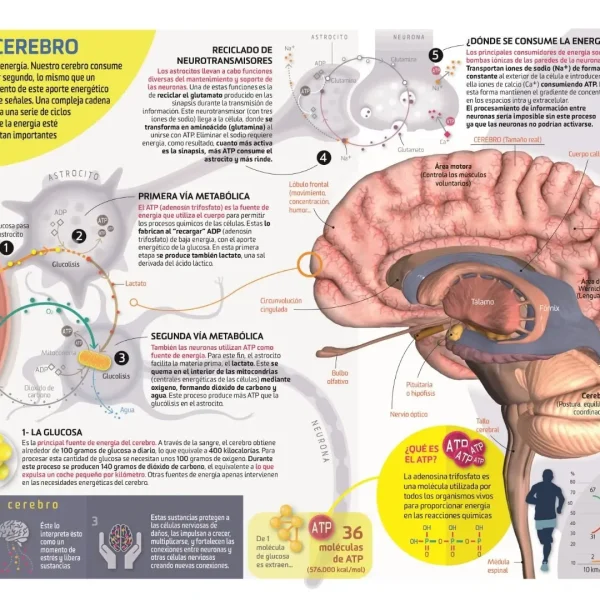

En un reciente artículo de El País, el modelo chino de IA DeepSeek fue denominado «cerebro digital», sugiriendo una comprensión del contexto geopolítico más allá de lo que una máquina puede procesar. Al utilizar el término «cerebro», se corre el riesgo de inferir que la IA tiene habilidades cognitivas similares a las humanas. Mientras que este enfoque puede facilitar la comprensión del funcionamiento de la tecnología, también puede evocar la ilusión de que los sistemas computacionales pueden emitir juicios o recordar contextos, una capacidad que actualmente se escapa de la realidad técnica de la IA. Al traducir competencias abstractas a habilidades familiares, se abre un camino al malentendido que confunde la correlación estadística con una verdadera comprensión semántica.

Otro ejemplo notable se encuentra en las discusiones sobre «IA emocional», donde se plantea la posibilidad de que las máquinas sientan y experimenten emociones. Reportajes como el de ABC destacan esfuerzos por dotar a los sistemas de IA de un «sistema límbico digital», lo que dramatiza la innovación y acerca la tecnología al público. Sin embargo, presentar a la IA como un «sujeto emocional» distorsiona la realidad, dado que los sentimientos humanos están ligados a la existencia corporal y la autoconciencia; cualidades que la IA, por su naturaleza, no puede poseer. Así, se tiende a desplazar la carga ética de la interacción humano-máquina hacia los algoritmos, desdibujando la responsabilidad de quienes crean y programan estas tecnologías.

Desde la perspectiva del cuidado, los robots humanoides han sido presentados como «cuidadores» de ancianos en un contexto donde la crisis demográfica es apremiante. Al describirlos como máquinas que «cuidan de sus mayores», se legitima su uso y se apacigua el temor tecnológico al recontextualizar su función como una extensión del cuidado familiar. Aunque esta metáfora es útil, también plantea cuestiones éticas sobre la responsabilidad en el cuidado, especialmente en un entorno donde una máquina, gestionada por corporaciones privadas, asume roles tradicionalmente humanos. Esta relación plantea interrogantes sobre la calidad del cuidado y la deshumanización del mismo en un sistema que minimiza la intervención humana.

La tendencia de los medios a recurrir a metáforas en la coverage de la IA sirve varios propósitos. En primer lugar, facilita la comprensión de conceptos complejos. En segundo lugar, crea una narrativa atractiva que capta la atención del lector. Y en tercer lugar, permite formular juicios morales sobre la tecnología. Sin embargo, estas metáforas pueden obstaculizar una deliberación pública crítica sobre la IA, haciendo que sea más difícil distinguir entre la capacidad real de la tecnología y las expectativas humanas. Para abordar esta problemática, es fundamental que periodistas y editores utilicen un lenguaje crítico, proporcionando un equilibrio entre la evocación emocional de las metáforas y la precisión conceptual necesaria para seguir debatiendo de manera informada sobre el futuro de la inteligencia artificial.